影像级标注+伪标签生成技术,助力术中实时导航标定动态病灶

近日,中国科学院深圳先进技术研究院梁晓坤团队,在弱监督学习在医学影像语义分割和分类定位中的研究中取得新进展。通过结合影像级标注和伪标签生成技术,显著提升了病灶的分割和定位精度,为影像引导治疗、实时病灶识别和术中精准实时导航等应用场景提供了新的解决方案。本研究在降低标注成本的同时,提升了模型性能。

相关成果在期刊IEEE Transactions on Industrial Informatics上以“Weakly-supervised Semantic Segmentation via Dual-stream Contrastive Learning of Cross-image Contextual Information”为题,在期刊Expert Systems With Applications上以“Hybrid Multiple Instance Learning Network for Weakly Supervised Medical Image Classification and Localization”为题分别进行了发表。

文章上线截图

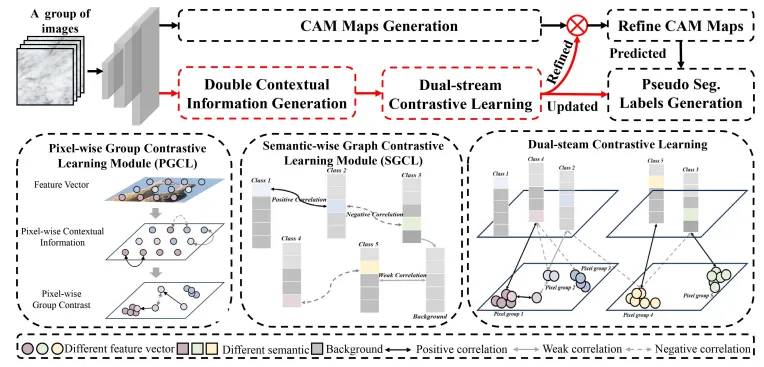

双流对比学习框架(DSCNet)

实现了同时利用像素级和语义级跨影像上下文信息的学习。DSCNet的核心创新在于其能够同时处理像素级和语义级上下文信息,为弱监督学习在其他计算机视觉任务中的应用提供了新思路。

相比传统方法仅关注单一影像内的像素信息,DSCNet通过对比学习机制,在数据集中挖掘出类别间的全局关联性,从而生成更加精确的伪分割标签。

双流对比学习框架流程图

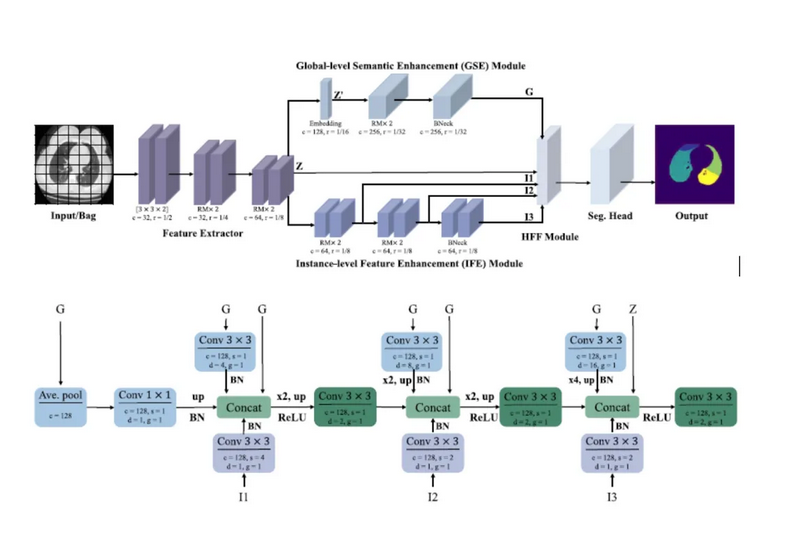

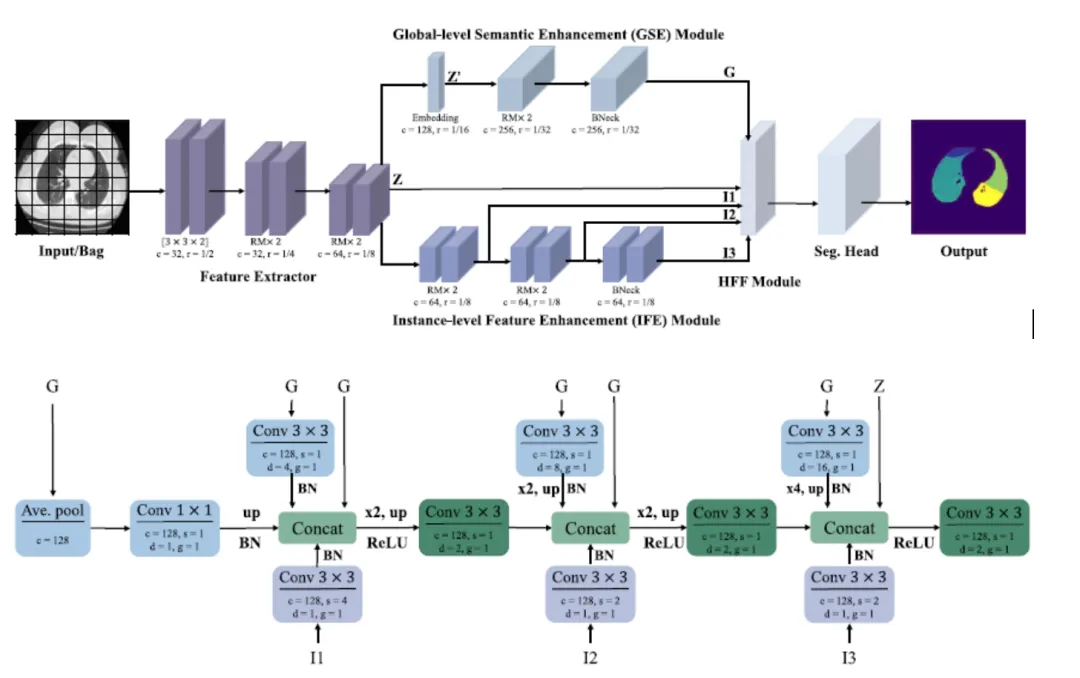

混合多实例学习框架(HybridMIL)

将卷积神经网络(CNN)和宽学习系统(BLS)整合为统一框架,用于弱监督医学影像分类与病灶定位。HybridMIL设计实例级特征增强模、全局语义增强模块,以及混合特征融合模块。

这些模块协同工作,有效提取多尺度特征信息,捕获实例间相关性,并融合全局语义信息,从而显著提升了医学影像的分类和定位能力。在胸部X光、计算机断层扫描(CT)、病理等多个公开数据集中进行了验证。实验结果显示,HybridMIL分类性能提高了最高9%,定位精度也超越了目前主流方法。

混合多实例学习框架流程图与模型细节

后续,研究团队在进一步优化算法的泛化能力,并探索多模态数据的融合分析,以应对更加复杂的影像引导治疗场景。结合医学影像大模型的优势,有望提供更加精确的靶区定位,为术中实时导航提供动态的病灶标定,并显著提升多模态影像数据在复杂医疗决策中的协同作用。

深圳先进院赖琪博士为论文第一作者、梁晓坤副研究员为通讯作者。本研究工作获得科技部国家重点研发计划、国家自然科学基金项目、深圳市基础研究计划等项目的支持。